Правильный файл Robots.txt для WordPress 2015

И снова Здравствуйте! На связи Владимир Савельев, с очередной порцией полезных знаний, в области сайтостроения на движке Вордпресс. Сегодня поговорим о таком важном файле как — Robots.txt для WordPress и не только.

В прошлой статье кстати, я рассказал Вам как сделать слайдер на Вордпресс, кому интересно обязательно почитайте...

Robots.txt для WordPress – специальный текстовый файл, который содержит служебные инструкции по индексации, адресованные роботам поисковых систем. Данную электронную запись составляют в обычном блокноте и размещают в корневой директории web-проекта, что позволяет ботам проводить индексацию страниц именно по ее правилам.

Robots.txt является одним из самых важных файлов для интернет-ресурса. Его наличие – неотъемлемое условие для качественной оптимизации проекта под поисковые системы.

Общеизвестно, что в сайтах на движке wordpress имеется множество копий (дублей) основного контента, снижающих его уникальность, что грозит серьезными штрафными санкциями от поисковых ботов.

Грамотно настроенный роботс существенно облегчит работу роботов поисковиков, улучшит индексацию ресурса и не даст засорять поисковую выдачу дублированными записями и прочим ненужным мусором.  Пользуясь этим файлом, можно скрывать от индексации разделы ресурса, которые содержат определенную информацию и рассчитаны на целевую аудиторию, а не на ботов поиска.

Пользуясь этим файлом, можно скрывать от индексации разделы ресурса, которые содержат определенную информацию и рассчитаны на целевую аудиторию, а не на ботов поиска.

Кроме того, Robots.txt поможет ограничить доступ на сайт различных спамерских программ, сканирующих ресурс на наличие emails с целью последующего засорения спам информацией.

Образец правильного файла Robots.txt 2015 года

Представляю вам оптимальный вариант готового файла robots txt для ресурса на движке wordpress. Для одного web-проекта требуется одна такая электронная запись, содержащая инструкции для роботов всех поисковиков. Создавать отдельные роботс файлы под каждую поисковую систему не нужно.

Стандартный образец robots.txt:

[sociallocker]

User-agent: *

Disallow: /wp-includes/

Disallow: */feed

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Sitemap: https://savme.ru/sitemap.xml

Host: savme.ruUser-agent: Googlebot-Image

Allow: /wp-content/uploads/User-agent: YandexImages

Allow: /wp-content/uploads/

[/sociallocker]

Понятно, что в графу «ваш домен» необходимо прописать адрес вашего ресурса.

Разберем по порядку, какая строка за что отвечает.

- User-agent – директива поиска, которой обозначается – к какому поисковому боту адресована данная инструкция. У каждого поисковика есть свои ключевые роботы (Google, Yandex) и еще десяток специфических, а также специальные боты, сканирующие микроразметку ресурса. Если вы задаете одинаковые правила для всех поисковых роботов, в директиве User-agent прописывается символ «звездочка» (*);

- Allow – директива, при помощи которой вы индексируете и добавляете к поисковой выдаче страницы, разделы и ссылки;

- Disallow – команда, налагающая запрет на индексацию выбранных директорий ресурса. Используется для запрета индексировать панель админа, служебные разделы и удаления дублированных (копий) страниц. Под копиями понимают идентичные страницы, доступ к которым открыт по разным адресам;

- Sitemap – директива, указывающая поисковому боту на местоположение карты ресурса, отражающей структуру его материалов. Здесь прописывается адрес карты web-проекта (используется заархивированный вид или формат XML). Важно! Обязательно проверьте, что через данный адрес действительно открывается карта сайта;

- Host – директива адреса или главного хоста вашей web-площадки. Совпадает с ее доменным именем.

Почему я открыл доступ индексации для ПС к некоторым папкам?

В свете последних событий, я уверен, что у большинства блогов на WordPress — Robots.txt не совсем правильный! Не веришь?! Сейчас объясню почему...

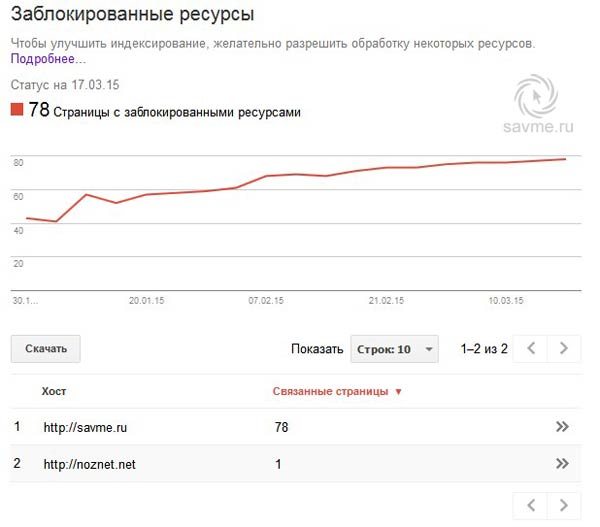

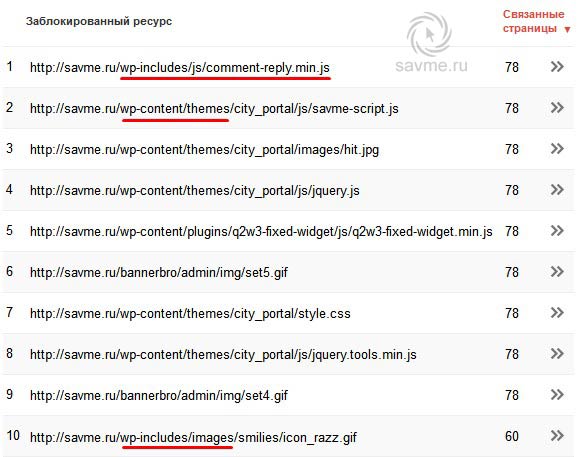

Так вот, дело было так! Как обычно анализируя свой блог на самые разные параметры, зашел в кабинет веб-мастера Google, во вкладку — индекс Google — Заблокированные ресурсы и упал со стула ![]()

Как видно из скрина, почти все страницы содержат ошибки из-за того что ПС не может нормально прочитать файлы...

Как видно из скрина, почти все страницы содержат ошибки из-за того что ПС не может нормально прочитать файлы...

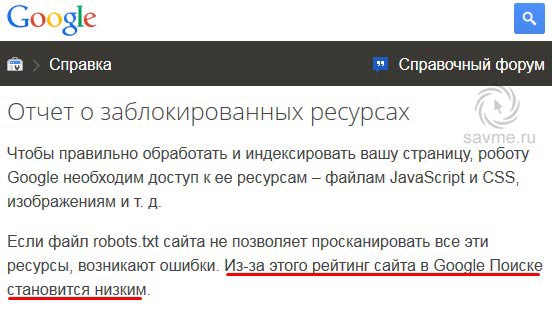

А вот что пишет сам Google:

Ну я думаю теперь Вам стало все понятно?! Нужно открыть доступ в Robots на скрипты, стили, картинки! Короче, исправляем ошибки которые там указаны, в моем случае — это:

Так вот, смотрим какие ресурсы Google не может прочитать на Вашем сайте и вносим правку в стандартный образец robots который я давал выше. То есть даем разрешение для ПС (параметр Allow) на определенные пути к папкам, которые он не может прочитать!

Посмотрите пример моего документа — https://savme.ru/robots.txt, если что не поняли... И не забудьте рассказать об этом своим друзьям! Я вот случайно обнаружил, так бы и не знал об этом...

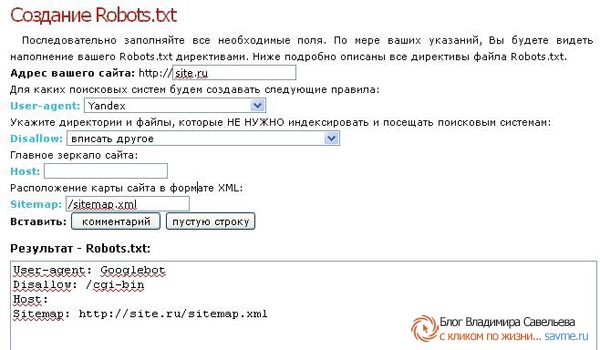

Делаем Robots.txt для WordPress при помощи конструктора

Если у вас нет времени на самостоятельную работу с роботс или вы опасаетесь, что не справитесь, можно сгенерировать нужные директивы при помощи несложного конструктора, например тут.

1. В первой графе прописываем адрес сайта;

2. Далее конструктор предложит вам определить поисковик, под который станут задаваться инструкции. Вы можете подобрать несколько поисковых систем;

3. Следующий шаг – выбираем папки и файлы, для которых будет закрыт доступ; прописываем адрес зеркала ресурса и указываем месторасположение его карты;

4. По ходу наполнения граф, внизу начнут отображаться необходимые директории. Скопируем их в txt файл и зададим ему название – robots.

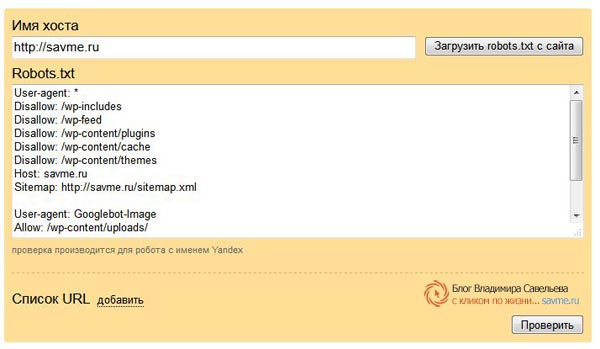

Проверка robots.txt на эффективность

А сейчас проанализируем, насколько эффективна работа файла роботс в системе поиска Yandex. Открываем раздел Yandex Webmaster и переходим к соответствующей вкладке. В диалоговом окошке указываем название ресурса и нажимаем кнопочку «загрузить».

Сервис проведет анализ эффективности вашего роботс и сделает вывод – будут ли поисковые роботы обходить страницы, на индексацию которых вы наложили запрет. При возникновении проблемных ситуаций, директивы можно исправлять, редактируя их прямо в диалоговой строке.

Закончив правку, обновленную версию записи необходимо скопировать и добавить в файл robots.txt, расположенный в корневой директории. Подобной услугой можно также воспользоваться и в сервисе «Инструменты для web-мастеров» поисковой системы Google.

На этом все! Если есть какие-либо вопросы пишите в комментариях, Вам обязательно кто нибудь ответит, возможно даже я ![]()

Дорогие друзья! Впереди еще очень много полезного материала, если Вам реально интересна тема создания сайтов и блогов на Вордпресс, а так же Я — как автор, то рекомендую подписаться на обновления блога! Сделать это можно в любой форме подписки — куда кот показывает ![]() По секрету скоро запущу интересный конкурс.

По секрету скоро запущу интересный конкурс.

Вот что Яндекс говорит про Robots

Всего Вам только самого хорошего...

С уважением, Владимир Савельев

Спасибо уже поменял! А вот насчет файлов и папок еще не очень понятно, когда нужно создать свою папку, то ее нужно куда то заносить?

смотря что за папка Василий если для индексации она не нужна то пропиши и ее там

Ага я понял, просто по разному говорят, вот Борисов говорил в курсе 3.0 что нужно указывать туда все свои папки, а кто то говорит что не нужно, вот немного запутался. Но спасибо тебе!

А я с роботсом игрался очень долго, после того как форум добавил на сайт. Это был какой то ужас. Ну вроде бы разгреб.

Так, ну вроде всё правильно было) Спасибо тебе, Вов за полезную информацию!

С этим robots я уже запутался. Кто что советует.

Кто то перекрывать от индексации рубрики а у меня на них трафик с поиска идёт.

К примеру сейчас настраиваю 1 видео сайт там основную внутреннюю ссылочную массу планируется лить именно на рубрики так как основное описание будет там.

Ещё и с дублями которые одни пытаются перекрыть в robots, другие советуют этого не делать так как в коде вордпресса уже есть значения которые распознают дубли коментов

Короче полнейшая ОПА и голова кругом

Александр да эт точно! Сколько людей сстолько и мнений! Кто на что горазд! Больно уж не заморачивайся а то точно с ума сойдешь

а то точно с ума сойдешь

Да, сложное это дело. Кому то подходит, а кому то нет.

Главное не переусердствовать друзья, а то можно и нужное запретить или вообще нарушить нормальную индексацию

или вообще нарушить нормальную индексацию

Ну да, и такое бывает. Ну это время покажет Если трафик упадет, то будет все ясно

Если трафик упадет, то будет все ясно

Может сайт индексироваться без Sitemar карты, но при этом иметь robots.txt?

Конечно может — но желательно его иметь

Конечно может, вы тогда в роботсе не прописывайте sitemap только.

здравствуйте я не моту войти в админ панель вортпрес выходит вот такая надпись что делать ?

Fatal error: Cannot redeclare _verifyactivate_widgets () (previously declared in /home/u552813338/public_html/wp-content/themes/interface/functions.php:169) in /home/u552813338/public_html/wp-content/themes/interface/inc/functions/functions.php on line 354

Всякое может быть! Возможно не правильно адрес ввели админ.панели?

нет правильный

какая-то ошибка в functions.php — в последнее время изменяли его? Устранить возможно теперь лишь через FTPклиент, либо сделать бэкап...

нет не изменял установил бесплатную тему после этого так получилось как исправить помогите пожалуйста подскажите как ?

как исправить помогите пожалуйста подскажите как ?

какой у Вас уровень знаний? Я так понимаю если бы были знания, не спрашивали бы Значит нанять спеца какого-нибудь! Можно и меня

Значит нанять спеца какого-нибудь! Можно и меня

Тут нужно либо удалить эту глючную тему, поставить оригинальную, либо переустановить сам Вордпресс, либо поковыряться в функтион и найти ошибку! Вариантов масса...

спасибо большое за ответ ) а как вордпресс переустановить через фтп самого хостинга ?

Статья Вам в помощь Руслан

Залить движок в корневую директорию, настроить базы данных если были

savme.ru/prostaya-ustanov...ng-adminvps.html

savme.ru/kak-sozdat-blog- ...a-wordpress.html

savme.ru/chto-takoe-khost...i-nedorogoj.html

Нельзя было роботс в нормальном виде выложить, чтобы скопировать можно было?

Исправил Копируйте на здоровье

Копируйте на здоровье

Вот сколько мануалов в свое время по роботсу прочитал, а так и не понял, правильный роботс у меня или нет...пока посетители с ПС идут буду считать что правильный

Виталий не совсем правильный у тебя Роботс

ДА??? А подскажешь что там нужно исправить??

Домен должен быть один основной а у тебя их два. Карта сайта одна. Так же зайди в кабинет google — индекс — заблокированные ресурсы и глянь что там...я об этом в статье писал

Спасибо Вов, вроде разобрался...сейчас кажись настроил, буду следить как поисковики поведут себя

Огого сколько у меня этих заблокированных ресурсов оказалось...сейчас буду ковырять...и тут же два вопроса на старте:

1. Если гугль говорит что нужно некоторые js из плагинов разблокировать делать это?

2. Сейчас только настроил хост один и одну карту сайта, роботс отправил гуглю и он его вроде уже принял. Вопрос: как скоро данные в «заблокированных ресурсах» переиндексируется??

Виталий ну если ПС говорит надо значит надо Во всяком случае я открыл доступ!

Во всяком случае я открыл доступ!

На счет переиндексации должно пройти 3-4 дня и ошибки будут постепенно исчезать- у меня так — сначало было 88 потом все меньше и меньше — сейчас 8 скоро 0 будет!

Удивительный факт кстати если запретить в robots.txt доступ к к определенному ресурсу но на страницах сайта будет ссылка на этот ресурс ПС все равно заберет его в индекс а если разрешить то не заберет

а если разрешить то не заберет

Судя по всему алгоритмы поисковиков терпят кардинальных изменений. Или это мои мозги терпят кардинальные перемены и я узнаю то, о чем еще недавно ни сном ни духом

Блин, не могу понять в чем беда, дней пять уже как трафик с Яши неизменно падает, и хоть ты тресни не могу понять в чем беда. Надеюсь что после исправлений роботса все изменится, хотя сильно себя надеждами не тешу

Гугль при этом растет постепенно...хоть убей не понимаю

Анализ и еще раз Анализ сайта помогает выявлять причины Да в принципе одинаковых показателей быть и не должно это совершенно разные ПС ))

Да в принципе одинаковых показателей быть и не должно это совершенно разные ПС ))

А яша чудит иногда, я и сам не раз замечал ни с того ни с сего трафик с него падает почти до 0, человек 7. Так висит чуть ли не неделю и опять погнал на свои позицию. Ну для меня это обычно человек 20-25.

тараканов мне в плагины...кажись разобрался наконец-то, теперь нужно две недельки подождать и посмотреть на изменения. Вов, сегодня, навскидку с роботсом все в порядке? Посмотри если не трудно

вроде бы с виду правильно только поменяй местами host и sitemap. host должен быть после...

Спасибо, сейчас сделаю

Опачки, а я даже и не знал, что последовательность важна. Сейчас и у себя проверю.

Что то не совсем понял... Нужно составить новый роботс и заменить им старый?Цитата: "Закончив правку, обновленную версию записи необходимо скопировать и добавить в файл robots.txt, расположенный в корневой директории. " Добавить или заменить? Да и вообще не совсем понятно из этой статьи, что нужно делать!!!??? Не могли бы Вы поподробней раскрыть тему?

Куда уж подробнее то Александр?! Если у Вас Вордпресс в статье есть стандартный роботс! Копируете его, открываете свой роботс все удаляете оттуда и вставляете записи!

Если хотите более правильный роботс для вашего сайта, то смотрим google кабинет — заблокированные ресурсы! И вот все что там заблокировано, разрешаем в роботс командой Allow

Роботс такого вида уже не пойдёт? Обязательно чтобы был как Вы описываете в этой статье? Или это не важно?

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /wp-trackback

Disallow: /wp-feed

Disallow: /wp-comments

Disallow: /category/

Disallow: /author/

Disallow: /page/

Disallow: /tag/

Disallow: /20*

Disallow: */trackback

Disallow: */comments

Disallow: /*.php

Sitemap: _http://site.ru/sitemap.xml

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /wp-trackback

Disallow: /wp-feed

Disallow: /wp-comments

Disallow: /category/

Disallow: /author/

Disallow: /page/

Disallow: /tag/

Disallow: /20*

Disallow: */trackback

Disallow: */comments

Disallow: /*.php

Host: site.ru

Sitemap: _http://site.ru/sitemap.xml

Александр мое мнение что в вашем роботс много чего лишнего, например для чего Вы делаете сначала записи для всех ПС и тут же для Яндекса? Он что требует отдельных записей?

На счет путей нужно смотреть! Зачем закрывать /category, page, comments и так далее не проще настроить каноникал?

Host желательно в конце прописывать! Какой у Вас движок то?

Я бы весь Ваш роботс переработал... этот не годиться ни куда!

В кабинете google смотрели заблокированные ресурсы?

У меня тоже вначале было отдельно для яндекса, где то такой вариант в нете нашел, а потом удалил, так как посчитал, что это не нужно.

Здравствуйте, Владимир! Движок Вордпресс. Заблокированные ресурсы смотрел и переделал роботс, как Вы советуете... Этот файл мне сделал один вебмастер. Как настроить каноникал я не знаю, и вообще этому файлу я поначалу не уделял должного внимания. В интернете вообще какая то размытая и неопределённая информация о роботс — одни с пеной утверждают, что мой вариант правильный, Вы говорите обратное, а зачем он вообще нужен никто не объясняет вот поэтому многие новички и забрасывают свои блоги...

Александр могу утверждать то что для каждого сайта robots.txt уникален! Сейчас поисковые системы настолько продвинуты что в принципе можно обойтись и без него... Для чего вообще нужен этот документ? Чтобы запретить ПС доступ к определенным папкам, которые мы не хотим обнародовать...

Правило следующее в этом документе — что не запрещено, то разрешено

Опять же смотрим какие страницы попали у нас в индекс — допустим там находиться страница которая не должна быть проиндексирована или мы не хотим чтобы она была в индексе, тогда смело прописываем запрет в роботс на определенную папку...

Каноникал настроить очень просто в таких плагинах как Platinum SEO Pack или ему подобных... Посмотрите видео от Яндекса там все понятно объясняют

Владимир, спасибо за разъяснения и терпение (некоторые начинают психовать и не отвечать). У меня плагин Yoast Seo, там никаких каноникалов я не нашёл (раза три пересмотрел). На этом у меня всё! Можете не отвечать, я получил исчерпывающие объяснения! Спасибо за ценную информацию насчёт заблокированных страниц, у меня они оказались заблокированы все.

Привет Александр у меня много терпения По моему твой плагин автоматом каноникал прописывает глянь в html исходном коде rel="canonical" присутствует?

По моему твой плагин автоматом каноникал прописывает глянь в html исходном коде rel="canonical" присутствует?

Всегда пожалуйста заходи чаще

Да присутствует! Пустые комменты (мои) удалите пожалуйста

Блин, очень я похоже вовремя сделал эти изменения. У меня оказывается в яндекс вебмастере была другая карта сайта по умолчанию, старая, которую я бахнул уже. А благодаря настройкам роботса заметил и этот лаг. Правда позиции в яндексе капец как попадали, но я надеюсь что после переиндексации все изменится

Виталий,вот на таких нюансах мы и обжигаемся.

Обидно,досадно,но ладно.

Ну как, Виталий, уже все наладилось?

А где находится корневая директория? Куда закачивать этот файл?

Корневая директория находится там, где лежат папки и файлы движка WordPress! Обычно это папка с названием (домен) вашего сайта!

Вопрос такой, а Яше тоже стоит лезть в /wp-content и /wp-includes? Он вроде не жаловался. Вот я и прописал, отдельно для гугла и отдельно для Яндекса. Гуглу открыл достоп, а Яше нет.

Саня а что ты там такого скрываешь от Яши? $) Я думаю все равно в будущем нужно будет, так как Яшка идет по следам гуугла, правда отстает не по детски

В принципе, согласен. Нужно будет все-таки внести коррективы в свой роботс. К тому же посмотрел на Ваш. Вы открыли не полностью доступ в wp-includes, а только для двух папок. А я что-то по щедрому полностью доступ открыл. Сегодня подкорректирую маленько.

Спасибо попробую заметить, а то я мало понимаю в этом что. А картинки будут индексировать и с гугла и яндекса?

Конечно же Ольга

Спасибо. Я сейчас проверяю ошибки, но почему-то все равно стоят. Они не сразу исчезают? Я проверяю в Инструмент проверки файла robots.txt в гугле...

Ольга через определенное время... следите ежедневно за изменениями!

Спасибо еще раз, очень помогли не знала что делать. Сегодня села уже поискать и нашла вас. Из всего что советовали многие, вы убедили меня больше. Желаю вашему сайту процветания )))

Всегда к Вашим услугам =) Спасибо!

У меня почти такой же файл robots.txt

Спасибо Владимир наконец та разобралась я с этим чудо тхт файлом)

Володь,на скрине в статье видел еще таку. ссылку на сайт _noznet.net

Это ваш игровой сайт?

Нет я тогда флаш игру в статью делал, вот ссылка и нарисовалась =)

Понятно.А я думал твой сайтик.Хотел поинтересоваться как прибыль.

А то кто что говорит.

Сколько блогов, столько и мнений на счёт файла robots. Я вот недавно ещё один домен зарегистрировал для эксперимента. Думаю какой лучше robots сделать. У многих всё открыто для индексации, а у некоторых он вообще на полторы страницы.

Саня,ну если все пооткрывать,тогда смысл от этого роботса?

Гугл и так чхал на роботс

Всё открывают потому что поисковые системы любят когда сайты полностью открыты для них.

Да это то понятно.Но все же нужно что бы некоторые файлы были закрыты.

Несколько раз за пару лет я переделывал файл robots.txt, пока не пришёл к тому варианту, который имею сейчас...